기술은 하나의 방법이다. 기술은 자랑하는 것이 아닌 ‘이야기’를 들려주기 위한 선택이다. 기술적 성취를 부각시키다 보면 결국 전달하고자 했던 메시지와 진정성을 제대로 보여 줄 수 없을 것이다. 처음 AI 기술을 만나 제작했던 <얼라이브>는 기술적 성취를 자랑하는 ‘쇼케이스’가 아닌 고인이 된 故유재하님과 故임윤택님의 음악과 삶의 이야기를 시청자들에게 전달하고자 기술을 매개체로 이용했다. AI 음성복원과 딥페이크 기술을 통해 복원된 故유재하님은 프로그램을 통해 35년 만에 신곡을 발표했고 故임윤택님은 9년 만에 ‘울랄라세션’ 완전체로 돌아왔다. 비록 TV 프로그램을 통한 잠깐의 만남이었지만 기술을 이용해 구현된 외형과 목소리는 시청자들이 감동을 느끼기에 충분했을 것이다.

1. 들어가며

2021년 엠넷(Mnet)에서 고인이 된 혼성그룹 거북이의 ‘터틀맨’, 그리고 ‘김현식’의 목소리는 물론 모습까지도 AI로 재현해 홀로그램으로 선보였던 ‘AI 음악 프로젝트 다시 한 번’을 선두로 본격적으로 버추얼 아바타를 내세운 프로그램이 연이어 런칭되었다. JTBC에서도 아바타가 소개팅을 하는 <러브 in>, 가상공간에서 음악 페스티벌을 여는 <뉴페스타> 등 신기술을 기반으로 하는 예능 프로그램들과 국내 최초로 100% 확장현실(eXtended Reality, 이하 XR)을 이용하여 텔레프제전스 로봇을 제작해 글로벌 석학들과 인터뷰를 진행했던 다큐멘터리 <A.C.10>, 고대 한국의 문화유산을 LED기반의 XR스튜디오에서 촬영한 <차이나는 클라스 K> 등을 선보였다. 기술은 빠르게 성장하고 있고 레거시 미디어들은 플랫폼의 경계선이 무너지고 있는 현 방송 제작 환경에서 시청자들의 눈을 사로잡기 위해 다양한 시도를 하고 있다. 이러한 시도에 AI, 메타버스 등이 등장한 것이다. JTBC의 음악 예능 프로그램인 <뉴페스타>의 경우 메타버스 공간 즉 가상의 공간에서 뮤지션들이 노래 공연을 펼치고 제작진 자체로 개발한 메타버스 앱 <JFesta>를 통해 동시에 방송을 보고 참여할 수 있도록 했다. 그리고 무대 중간 ‘떼창타임’과 ‘댄스타임’을 등장시켜 관객들이 메타버스 플랫폼 속에서 춤추기와 박수치기, 가수에게 메시지 보내기, 폭죽 터트리기 등의 기능을 넣어 적극적으로 공연을 즐길 수 있도록 했다.

2022년 하반기에 선보였던 JTBC의 <인생리셋 재데뷔쇼-스타탄생>은 고비용의 AI 기술을 사용하는 대신 스마트폰 얼굴 변형 앱인 스노우와 틱톡을 활용하여 태블릿 PC를 이용해 촬영하는 등 앱을 이용해 누구나 쉽게 접할 수 있는 예능이라는 컨셉으로 제작했다. 모션캡쳐 기술, 증강현실, 외형 음성 복원 홀로그램 기술 등 현재 방송가에서는 다양한 방법으로 새롭게 등장한 신기술을 접목해 창작자로서 실험정신을 발휘해 다양한 형태의 프로그램을 제작하고 있다.

2. 하이퍼 리얼리즘 버추얼 휴먼

새로운 프로그램에 대한 논의가 한창이었다. 그때 딥페이크를 이용한 프로그램 제작에 대한 아이디어가 나왔다. 그리고 AI를 이용해 음성을 복원할 수 있다는 이야기들이 오갔다. ‘이 둘을 조합하면 무엇을 할 수 있을까?’의 물음으로 시작된 것이 2022년에 선보인 <얼라이브>이다. 하지만 이미 타사에서 홀로그램 방식을 이용한 고인 복원 프로그램은 있었고 그 이상의 무언가가 필요했다. 그 즈음에 버추얼 휴먼에 대한 이슈들이 한창이었다. 그중에서도 실제 사람의 얼굴 질감을 99%까지 구현하고 미묘한 표정과 근육의 움직임까지 그대로 재연하는 버추얼휴먼 ‘루이’의 제작 방식을 알게 되었고 기존의 프로그램과 차별화를 둘 수 있는 포인트라고 생각했다. 또한 가족, 동료, 팬들이 기억하는 고인이 된 뮤지션의 실제 모습과 같은 질감과 목소리의 표현, 무엇보다도 중요하게 생각했던 입 모양 싱크 등의 효과를 최대로 반영하기에 적합하다는 판단과 앞서 이야기한 ‘그 무언가’를 채워 줄 수 있을 것이라 생각했다. 버추얼 휴먼 루이처럼 실제 사람의 질감으로 고인의 얼굴을 복원하기 위해서는 Full HD 규격의 영상들과 사진들이 필요하다. 故임윤택님의 경우 데뷔 무대라고 할 수 있는 <수퍼스타K 3> 출연 이후 약 2년간 활동하면서 남긴 Full HD급 방송영상 자료와 사진 자료들이 남아 있었다. 하지만 故유재하님은 찾을 수 있는 영상자료가 1987년 <젊음의 행진> 단 한 번 방송 출연이 전부였다. 또한 남아 있는 사진 자료 또한 20여 장에 불과했다. AI를 학습시킬 수 있을 만한 데이터양이 아니었다. 우리는 외형 복원을 담당했던 ‘디오비스튜디오(dobstudio)’ 기술팀과 논의 끝에 두 뮤지션의 복원 방식을 달리 하기로 결정했다. 얼굴 합성(Face Swap) 기술과 커스터마이징(Customizing) 기술을 이용한 복원 방식을 채택했다.

먼저 故임윤택님의 복원은 Full HD 규격의 영상 자료들과 이미지 자료들을 취합하여 이미지 생성 AI인 GAN(Generative Adversarial Network, 생성적 대립 신경망) 기술을 적용하여 모델링을 구축했다. GAN의 경우 두 개의 AI를 이용해 이미지 영상을 제작한다. 쉽게 말해 판별과 생성을 담당하는 두 개의 AI가 존재한다. 판별하는 AI는 고인의 데이터를 기반으로 생성 AI가 만든 이미지가 실제 고인의 이미지와 부합하는지 판별하도록 학습시키고, 생성 AI는 고인을 대신할 쉐도우 액터에게 덮어씌울 이미지를 만들어 판별 AI에게 검사를 받게 한다. 판별 AI는 생성 AI가 만든 이미지가 가짜인지 진짜인지를 구별해 내고, 생성 AI는 판별 AI가 진짜라고 믿게끔 만들어야 한다. 이렇게 오랜 기간 동안 반복적인 이미지 생성을 통해 알고리즘을 발전시켜 故임윤택님의 이미지를 생성한다. 이렇게 완성된 이미지를 고인을 대신할 ‘쉐도우 액터’에 최종적으로 딥페이크로 합성한다.

여기서 우리는 고인을 대신할 ‘쉐도우 액터’에 주목할 필요가 있다. 쉐도우 액터는 AI가 아닌 휴먼이다. 고인의 체형, 스타일, 의상, 몸동작, 습관 등 대중들이 기억하고 있는 고인의 모습과 100%에 가깝게 일치해야 한다. 이러한 모습은 단순히 얼굴과 체형이 비슷하다고 만들어지는 것이 아니다. 철저하게 분석된 고인의 모습을 학습시켜야 하는 것이다. 우리는 처음에 이러한 부분을 놓쳤고 외형적 모습 중, 키와 춤추는 모습만 일치하는 쉐도우 액터를 섭외했다. 고인의 트레이드마크인 짧은 헤어스타일, 얼굴형, 노래를 부를 때 표현되는 감정 등 고인과 일치하지 않은 모습을 보이면서 故임윤택님과 비슷하지만 어딘가 모르게 어색함이 존재했다. 거기에 쉐도우 액터의 이미지가 덧씌워지면서 어렵게 AI로 생성해 낸 이미지가 다른 사람의 얼굴로 보이기 시작했다. 쉐도우 액터의 보완이 필요했다. 수많은 오디션을 통해 故임윤택님과 체형, 춤추는 모습과 노래하는 모습이 비슷한 쉐도우 액터를 섭외했다. 그리고 약 3개월 동안 고인의 사소한 버릇부터 특유의 입술 깨무는 동작까지 일치하도록 연습을 시켰고 재촬영과 생성 AI의 이미지를 합성하는 작업을 통해 故임윤택님의 모습을 비슷하게 만들 수 있었다. 단순히 AI만을 이용한 복원이 아닌 AI와 휴먼의 학습이 만들어 낸 결과물이었다.

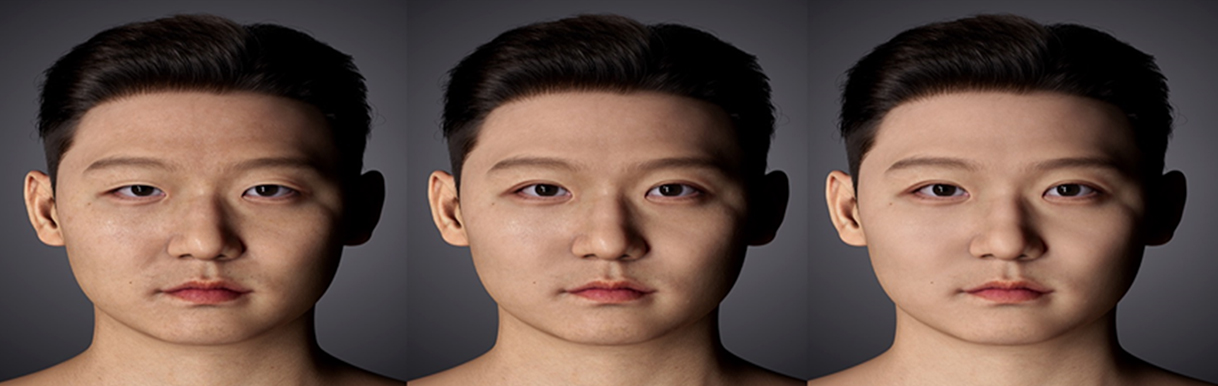

학습 데이터량이 현저히 부족했던 故유재하님은 고인과 얼굴 이목구비가 최대한 닮은 쉐도우액터 섭외를 우선으로 했다. 그리고 추가적인 유사성을 확보하기 위해 특수 분장을 통해 구축한 모델링 데이터를 기본으로 공간좌표적 속성값 변형으로 이목구비의 위치와 모양을 수정하여 기준값을 잡았다. 故유재하님의 남은 사진자료를 보면 촬영 시기와 각도에 따라 얼굴의 모양이 달리 보이는 현상이 있어서 최대한 유가족분들의 의견을 반영하여 기준값을 설정했다. 매주 10여 장의 이미지를 생성하여 약 4개월간의 유가족분들과의 회의를 통해 기준값을 찾을 수 있었다. 이렇게 마련된 이미지에 애니메이터, 합성팀이 6개월 동안 수많은 보정 작업을 통해 故유재하님의 이미지를 만들어 낸 것이다.

3. 세계 최초 가창 복제 합성기술을 이용한 신곡 발표

세계 최초 가창 복제, 합성기술 AI VOCAL을 이용하여 고인의 신곡을 발표했다. 특정인의 목소리 훈련을 통해 음색, 창법을 그대로 모델링한 가창 합성 AI를 이용한 것이다. 여기에 한국어 발음 체계를 구현하고 악보 읽기를 통한 가창이 가능한 만능 가수 AI를 구축함으로써 고인의 가창 데이터를 기반으로 곡 훈련을 통한 음성 생성 기술이다.

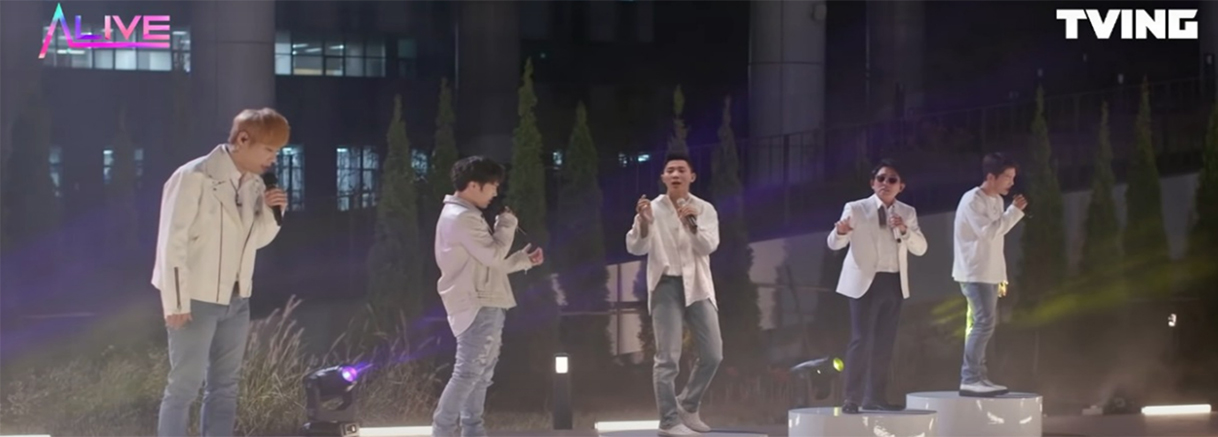

쉽게 말해 고인이 된 가수의 목소리를 모델링한 후 고인의 발음, 음색, 창법 등을 분석한 후 신곡, 미발표곡의 악보를 AI 학습시킴으로써 새로운 음원을 만드는 것이다. 故임윤택님의 생전 보이스트랙(음성 데이터)을 활용하여 고인의 발음 특성, 습관, 목소리 특징 등을 분석하여 8개 정도의 창법을 찾아내 보이스 모델링을 구축했다. 故임윤택님의 경우 트레이드 마크인 허스키한 목소리와 고음과 저음에서 나타나는 보컬의 특징을 적절하게 섞어서 고인의 목소리를 기억하는 가족, 팬, 시청자들에게 이질감이 없도록 전달했다. 이렇게 구축된 음성 데이터는 TTS(Text to speech)기반으로 AI 보컬 트레이닝에 들어간다. AI 보컬 트레이닝은 특정인의 가창 데이터를 이용한 훈련으로 음색, 창법을 그대로 모델링한 가창 합성 AI에 미발표 신곡의 악보를 학습시킴으로써 새로운 음원을 만드는 것이다. 이렇게 구축된 모델링을 이용하여 故임윤택님이 생전에 딸 리단이에게 들려주고 싶었지만 완성하지 못했던 곡 ‘낡은테잎’을 가수 휘인과 듀엣으로 제작했다. 또 10년 만에 울랄라 세션 완전체의 신곡 ‘얼라이브’는 고인이 된 가수가 지금도 살아 있다면 이런 노래를 부르지 않았을까? 하는 상상을 시작으로 최대한 故임윤택님의 느낌이 나는 신곡 ‘얼라이브’를 발표했다.

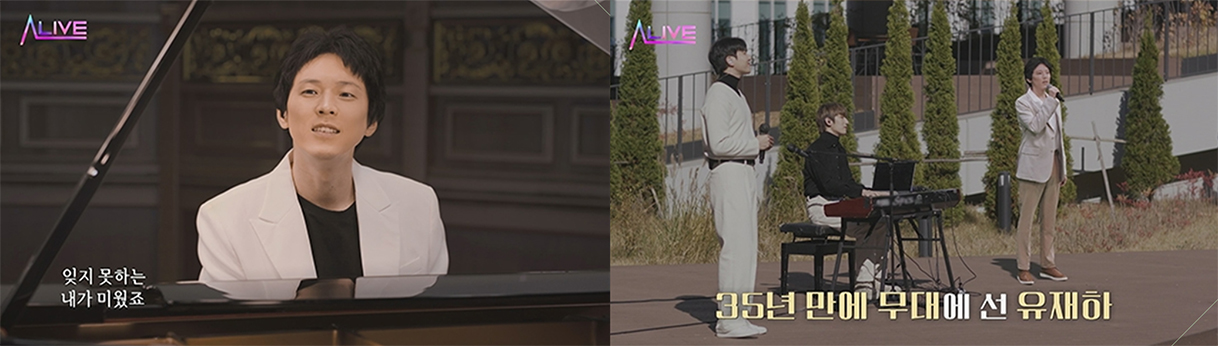

故유재하님의 과거 단 한 장의 앨범만 남긴 상태에 디지털화 음성 데이터가 존재하지 않았다. 이에 기존 앨범에서 음원 분리 기술을 이용해 故유재하님의 보이스 트랙을 확보했다. 하지만 100% 완벽한 음성 데이터를 확보하기 힘들었다. 음원 분리 기술을 통해 보이스 트랙만 추출했지만 우리가 노래방에서 노래를 부르면 나타나는 울림소리(리버브 현상)가 남아 있었다. 이에 음성복원 기술팀은 리버브 제거 기술을 연구개발해 약 40분 정도의 깨끗한 음성 데이터를 확보할 수 있었다. 여기에 故유재하님의 음악적 영향을 받은 작곡가 김형석, 김현철씨와 가수 심현보씨가 작곡 작사에 참여하여 35년 만에 신곡을 발표할 수 있었다. 여기에 제작진의 상상력 한 스푼을 더해 가수 김나영씨와의 듀엣곡을 완성했다.

비록 일시적인 만남이었지만 외형과 목소리를 실제와 가깝게 구현한 두 뮤지션의 모습과 목소리가 가족, 팬, 시청자들에게 좋은 추억으로 전달되길 바랐다. 그리고 프로그램 취지에 공감하여 참여해 준 기술 스태프들의 노력이 있었기에 가능했다.

4. 그 후로 1년 다시 시작된 리-얼라이브

2012년 불의의 교통사고로 척수장애(사지마비)판정을 받은 3옥타브 고음 샤우팅으로 주목받았던 김혁건과의 만남. 당시 ‘얼라이브’를 시청한 후 자신을 ‘AI로 만들어 달라’는 가수 김혁건씨의 제안으로 시작되었다. 2012년 교통사고 이후 가수 김혁건씨는 오랜 재활훈련과 배를 억지로 눌러주면 목소리가 나온단 사실을 발견하고 서울대의 도움을 받아 복압기까지 만들었다. 하지만 복압기를 사용할수록 그의 몸은 더 망가져 갔다. 경련이 일었고 배 안에서는 출혈까지 생겼다. 하지만 노래를 해야 살아 있음을 느낀다는 그의 고백에 험난한 복원의 과정이 다시 시작됐다. 리-얼라이브(Re-Alive)는 여러 가지 의미를 담고 있다. ‘다시’라는 의미의 ‘Re’와 ‘살아있다’라는 의미의 ‘Alive’ 그리고 ‘현실의’ 뜻을 가지고 있는 ‘Real’이 합쳐져 살아 있는 인물을 복원하겠다는 의미로 고인을 복원한 사례는 여러 차례 있었으나 살아 있는 인물을 복원한 사례는 없었기에 남다른 의미가 있었다. 기존의 얼라이브 방식을 통해 외형복원을 하되 이번에는 인물의 기본값을 설정하기 위해 3D 모델링을 선택했다. 디지털 복원 기술 중에서도 가장 진보된 ‘페이셜 익스페레션 캡쳐(Facial Expression Capture)’를 활용하여 평균연령 70대인 아바(ABBA)의 멤버들을 40년 전 젊은 시절의 모습으로 복원해 전 세계적으로 화제를 낳았던 버추얼 콘서트 ‘ABBA Voyage’의 Facial Capture Supervisor와 협업을 통해 더욱 현실감 넘치는 ‘로커 김혁건’의 모습을 구현했다. 국내 최초로 실존 인물의 얼굴을 360° 풀 3D방식으로 복원한 것이다.

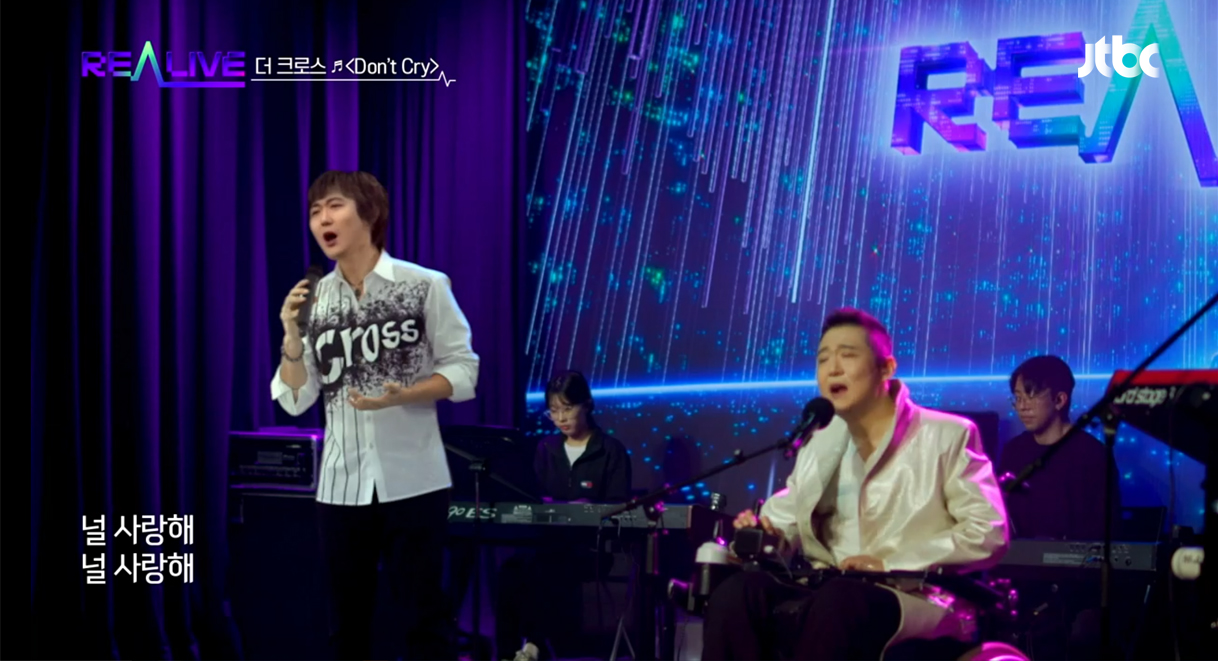

이렇게 탄생한 김혁건은 라이브 무대에서 휠체어에 앉은 김혁건 옆으로 전성기 시절의 모습으로 뚜벅뚜벅 걸어 나왔다.

데뷔시기의 강렬한 샤우팅의 목소리를 복원하기 위해 목소리의 구성요소인 음색, 발음, 음높이, 음량 네 가지를 다양한 조합으로 재합성하는 NANSY(Neural Analysis & Synthesis)방식과 기준 음성을 학습해 복제하거나 다양한 목소리 요소를 결합해 새로운 음성을 디자인하는 Voice Gene 등 1년 전보다 진일보한 기술을 적용했다. 건강 때문에 호흡이 짧아지면서 현실적으로 3~4분간 무대에서 노래 부르는 것이 불가능했던 환경에서 AI의 도움으로 무대에서 ‘더 크로스’의 음악 세계를 표현할 수 있었다.

이번 프로젝트의 주인공인 가수 김혁건은 “실제로 보니 예전으로 돌아간 것 같았다. 더 기술이 발전해 아바타가 또 다른 내가 되고, 그 아바타를 통해 노래하고 표현할 수 있다면 좋을 것 같다”라고 말했다. 김혁건의 파워풀한 고음은 물론, 관객들을 사로잡는 활발한 퍼포먼스를 실현하고자 AI 신기술이 총출동했다. AI 음성 복원 업체는 김혁건의 음성 데이터를 기반으로 3옥타브를 넘나드는 샤우팅과 음색을 구현하는 훈련을 거듭했고, 이어 외형 복원 업체 ‘3D 모델링’ 기술과 ‘디에이징(비주얼 데이터를 변형해 젊은 시절로 복원하는 기법)’ 기술을 적극 활용한 사례이다.

5. 마치며

최근 딥페이크를 이용한 범죄가 급증하면서 정부와 국회 그리고 관련 학계에서는 딥페이크 근절을 주제로 한 긴급 정책토론회 및 각종 규제 방안에 대해 논의 중이다. 지금까지 필자가 제작한 프로그램의 가장 중요한 기술 요소 중 하나가 딥페이크이다. 앞서 언급한 두 프로그램을 기획하면서 대중들에게 전달하고 싶었던 것 중 하나는 기술의 선한 영향력이었다. 프로그램을 제작하면서 항상 하는 말이 있었다. “기술을 누가 어떤 목적으로 사용하느냐에 따라 범죄가 될 수도 있고 좋은 도구가 될 수도 있다.”

프로그램 제작에 있어서도 기술을 자랑하는 것이 아닌, 유재하와 임윤택이라는 ‘사람’을 보여주기 위한 선택이어야한다.

기술을 이용해 아티스트를 복원만 하는 것은 의미가 없다. 그렇게 되면 그건 뮤지션을 이용해서 기술을 전하는 것이 된다는 것이다. 뮤지션에 대한 이야기를 하는데, 그냥 평범하게 하면 재미가 없지 않나. 이미 했던 이야기 같고. 지금의 새로운 기술을 얹어, 그 기술이 하나의 매개체가 돼 아티스트를 조명하는 것이라고 생각했다. 기술은 하나의 방법일 뿐이다.

올해도 신기술을 이용한 새로운 프로젝트를 연말에 선보일 예정이다. 신기술을 활용하여 콘텐츠 제작을 하는 것은 조금은 힘들고 어려운 과정이지만 창작자로서 호기심과 실험정신을 발휘할 수 있는 영역이다.

참고문헌

- 1) 티빙(2022). 오리지널 콘텐츠 <얼라이브>

- 2) JTBC(2022). JTBC 8월 26일, 8월 27일 TV 편성 <얼라이브>